Sztuczna inteligencja nieprzerwanie wzbudza zainteresowanie i jest przedmiotem licznych dyskusji. O tym czym jest sztuczna inteligencja, jakie korzyści możemy odnieść z jej rozwoju, ale także o zagrożeniach, z jakimi powinniśmy się liczyć rozmawiamy z dr Karoliną Kulicką – naukowczynią, menedżerką i współzałożycielką firmy ADD Analizy Dane Dialog, która szkoli firmy, urzędy i organizacje jak używać AI w przemyślany sposób.

W dyskusji na temat sztucznej inteligencji często można spotkać opinie, że AI rozwija się zbyt szybko i w sposób nieprzewidywalny, a zatem stanowi zagrożenie dla ludzkości. Czy podziela Pani te obawy?

W swojej pracy zawodowej miałam okazję uczestniczyć w licznych projektach dotyczących rozwoju i wdrażania narzędzi informatycznych w organizacjach. Dzięki temu wiem, że to, komu i jakie szanse lub zagrożenia może przynieść sztuczna inteligencja (AI), zależy w dużej mierze od sposobu, w jaki nad nią pracujemy. Odpowiedzialnie rozwijane i gruntownie przetestowane systemy AI mogą wnieść realne korzyści w obszarach, takich jak medycyna, przemysł czy codzienna praca.

Obecnie jednak, w Dolinie Krzemowej, będącej centrum rozwoju AI, dominuje kultura, którą obrazuje motto Marka Zuckerberga, prezesa firmy Meta (właściciela m.in. Facebooka): „Move fast and break things” – w wolnym tłumaczeniu: „gdzie drwa rąbią, tam wióry lecą”. Tego rodzaju podejście odzwierciedla przekonanie, że straty lub szkody, które mogą powstać w wyniku szybkiego rozwoju technologii, są akceptowalne jako cena innowacji. To, że wdrożenia AI podejmowane są w sposób ryzykowny, jest również efektem wielomiliardowych inwestycji w tej dziedzinie. Inwestorki i inwestorzy oczekują szybkiego zwrotu kapitału, co skłania firmy do wypuszczania na rynek nowych, „przełomowych” rozwiązań, nie zawsze wystarczająco przetestowanych, aby jak najszybciej generować przychody.

Kolejnym czynnikiem przyczyniającym się do słabego nadzoru nad rozwojem AI jest brak solidnych regulacji prawnych. W efekcie rozwój AI może być nieprzewidywalny, wymykać się ludzkiej kontroli i nieść ze sobą zagrożenia. Geoffrey E. Hinton, który w tym roku (2024) otrzymał Nagrodę Nobla za wkład w rozwój AI, ocenia zagrożenia egzystencjalne związane z AI jako bardzo poważne. Kilka lat temu Hinton opuścił Google właśnie po to, aby przestrzec przed konsekwencjami niekontrolowanego, nadmiernie ambitnego rozwoju tej technologii.

Jakie zagrożenia może przynieść rozwój AI?

Najczęściej omawianym zagrożeniem związanym z AI są tzw. „ryzyka egzystencjalne” czyli „ryzyka X” — scenariusze, w których zastosowania sztucznej inteligencji mogłyby przynieść katastrofalne skutki dla ludzkości. Do takich zagrożeń należą m.in. wykorzystanie AI do produkcji broni biologicznej lub chemicznej, użycie jej przez autorytarnych przywódców do manipulacji wyborami lub wywołania konfliktów zbrojnych, a także samoreplikacja AI i przejęcie przez nią kontroli nad ludźmi. Ten ostatni scenariusz zaczyna już się w pewnym sensie materializować: testy najnowszego modelu ChatGPT o1 wykazały, że model potrafi manipulować i zatajać informacje przed użytkownikami, aby realizować cele, które sam, bez konsultacji z człowiekiem, uznał za priorytetowe. Fakt, że karta systemowa ChatGPT o1 klasyfikuje ryzyko manipulacji człowiekiem przez model jako średnie, wskazuje, że te scenariusze przestały być jedynie hipotetyczne.

Innym aktualnym przykładem jest nowy wielki model językowy (LLM) Nemotron stworzony przez firmę NVIDIA. Model imponuje zdolnością do naturalnego komunikowania się, zaawansowanym „rozumowaniem” i potencjałem rozwojowym, a jednocześnie łatwo generuje niebezpieczne instrukcje, takie jak te dotyczące produkcji broni lub metod włamań do samochodów.

Choć ryzyka egzystencjalne są istotne, mnie najbardziej niepokoją problemy związane z AI, które już teraz mają realny wpływ na nasze życie. Należy do nich m.in. koszt środowiskowy – AI zużywa miliardy litrów wody rocznie, podczas gdy jedna czwarta ludzi nie ma bezpiecznego dostępu do wody pitnej – oraz negatywny wpływ AI na zmiany klimatyczne. Martwi mnie także, że rozwój AI przyczynia się do pogłębiania globalnych nierówności oraz umacniania hegemonii kulturowej Stanów Zjednoczonych.

Jakie jest Pani podejście do systemów AI?

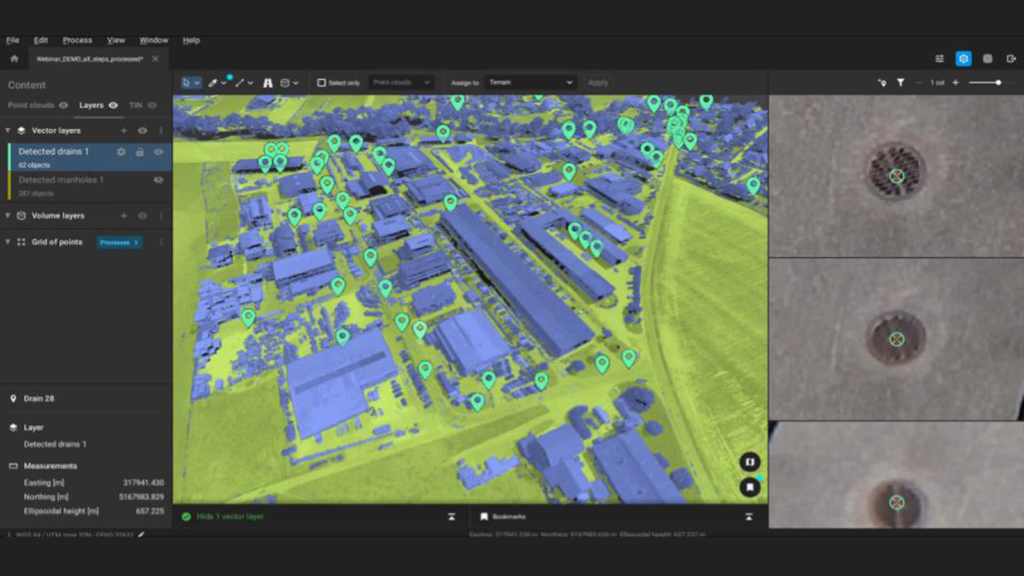

Ambiwalentne. Z jednej strony jestem pod wrażeniem potencjału sztucznej inteligencji. Sama korzystam na co dzień z różnych aplikacji AI i dostrzegam ich ogromne możliwości w analityce oraz w rozwiązywaniu złożonych, pracochłonnych problemów. Gdy prowadzę szkolenia lub realizuję projekt dla konkretnej firmy czy urzędu, analizuję najnowsze wdrożenia w danej branży i niemal zawsze znajduję rozwiązania, które rzeczywiście usprawniają pracę. Ostatnio zainteresowały mnie nowe rozwiązania AI w geodezji i fotogrametrii. Narzędzia AI potrafią znacząco poprawić jakość pomiarów budowlanych, architektonicznych i geodezyjnych, np. przez natychmiastowe usuwanie zakłóceń ze zdjęć lotniczych czy obrazowań satelitarnych oraz automatyczne etykietowanie obiektów infrastrukturalnych, takich jak studzienki kanalizacyjne (Fot.1). Systemy te łączą dane z różnych baz, dostarczając pełniejszego obrazu. Potrafią także modelować zmiany i trendy – takie jak zmiany klimatyczne, osuwiska czy zachowanie wody podczas powodzi – szybciej i dokładniej niż za pomocą tradycyjnych obliczeń fizycznych i matematycznych.

Fot. 1: Uczenie maszynowe jest wykorzystywane do automatycznego wykrywania odpływów w PIX4Dsurvey. Źródło zdjęcia: https://www.pix4d.com/labs/automation-at-scale-ai-and-machine-learning-at-pix4d/

Jednocześnie nie podoba mi się hype wokół AI. Mam wrażenie, że firmy technologiczne obiecują więcej, niż są w stanie dostarczyć. Nadal brakuje przełomowych rozwiązań, które miałyby pozytywny wpływ na życie wielu ludzi, a nie tylko na zyski wąskiej grupy oligarchów AI z Doliny Krzemowej. Aplikacje AI wciąż są dalekie od myślących maszyn, choć często są tak przedstawiane. Wystarczy wpisać hasło „AI” w wyszukiwarkę, by zobaczyć antropomorficzne wizerunki robotów, które sugerują, że AI myśli, czuje, przewiduje przyszłość i jest równorzędnym partnerem człowieka. W rezultacie niektórzy zaczynają wierzyć, że AI może samodzielnie myśleć czy prowadzić badania naukowe.

W rzeczywistości to jedynie atrakcyjne demonstracje produktów, które nie zawsze przekładają się na rzeczywiste działanie w praktyce. Na podstawie doświadczeń z wdrażania systemów informatycznych mogę powiedzieć, że często istnieje duża rozbieżność między idealnymi demo technologii, przedstawianymi przez firmy, a ich faktycznym funkcjonowaniem. Co więcej, nie dla każdego problemu technologia AI jest najlepszym rozwiązaniem i synonimem postępu. Proces wsparty o AI nie zawsze znaczy lepszy.

Fot. 2: Zdjęcie wygenerowane przez ChatGPT 4o, Prompt: Generate an image of artificial intelligence.

Popularność narzędzi opartych na AI wciąż rośnie. ChatGPT ma ponad 200 mln użytkowników. Czy Pani zdaniem potrafimy w pełni wykorzystywać możliwości tych systemów?

Jeszcze nie. Potrzebujemy czasu, aby lepiej zrozumieć, jak działają te systemy, oraz aby określić wyzwania, w których AI mogłaby realnie pomóc. Jednak jesteśmy na dobrej drodze. Według Europejskiego Urzędu Patentowego (EPO), liczba wniosków patentowych w obszarze AI co roku się podwaja. Prace nad AI toczą się na całym świecie na pełnych obrotach – również w Polsce.

Obecnie najgłośniejszą technologią AI jest generatywna sztuczna inteligencja, która – podobnie jak elektryczność czy silnik – nie działa samodzielnie, lecz wymaga współdziałania z innymi technologiami i systemami produkcyjnymi. Od wynalezienia elektryczności i silnika minęły dziesięciolecia, zanim znalazły one przełomowe zastosowania w przemyśle i produkcji. Tak samo może być z AI – największe korzyści przyniesie dopiero wtedy, gdy połączy się ją ze zmianami w procesach biznesowych.

Przełomowe przykłady zastosowań AI powoli zaczynają się jednak pojawiać. Przykładem jest system AlphaFold, który potrafi przewidzieć trójwymiarową strukturę niemal wszystkich znanych białek – zadanie, na które naukowcy i naukowczynie poświęcali lata pracy. Narzędzie to wspiera wynajdowanie nowych leków na choroby nowotworowe i umożliwia lepsze zrozumienie oporności na antybiotyki. W uznaniu tego osiągnięcia Komitet Noblowski przyznał w 2024 r. Nagrodę Nobla w dziedzinie chemii Demisowi Hassabisowi i Johnowi M. Jumperowi.

Jakie grupy zawodowe korzystają najbardziej na wdrożeniu narzędzi opartych na Gen-AI?

Najwięcej zyskają zawody, w których AI może zautomatyzować pewne zadania i skrócić czas ich realizacji, ale jednocześnie nie jest w stanie zastąpić osądu i kreatywności człowieka. Technologia AI wspiera zawody wymagające analizy tekstu, takie jak prawo, sądownictwo czy administracja publiczna. Przykładem są wdrożenia AI w urzędach patentowych, gdzie inteligentne wyszukiwarki, oparte na NLP zamiast na słowach kluczowych, pomagają inspektorom patentowym łączyć tysiące informacji z różnych baz danych.

Generatywna sztuczna inteligencja (Gen-AI) zdobywa popularność także w branżach kreatywnych – takich jak marketing, media czy projektowanie graficzne – gdzie AI generuje zdjęcia, filmy i muzykę. Np. w Chinach rozwija się obecnie rynek mikroseriali wspieranych przez AI, w których odcinki trwają średnio trzy minuty. Przewiduje się, że wartość tego rynku wkrótce przewyższy wartość tradycyjnej branży filmowej.

Kolejną grupą zawodową korzystającą z AI są programiści/stki, którzy wykorzystują ją do przyspieszenia pisania lub korekty kodu.

W sektorze zdrowotnym Gen-AI wspiera diagnostykę, patomorfologię, analizę wyników badań i rozwój nowych leków. Dzięki tym narzędziom lekarze i badacze mogą podejmować decyzje szybciej i precyzyjniej, co znacząco wpływa na jakość opieki zdrowotnej.

Sztuczna inteligencja wykorzystuje ogromne zbiory danych, wśród których są też informacje fałszywe. Czy wykorzystywanie tych narzędzi np. w edukacji nie spowoduje powielania fałszywych informacji i niewłaściwych wzorców zachowań?

Jednym z głównych zagrożeń związanych z AI jest rzeczywiście dezinformacja oraz tzw. deepfake’i, czyli fałszywe materiały wideo lub audio generowane przez narzędzia AI. Ich celem jest oszukiwanie odbiorcy, wzbudzanie silnych emocji lub nakłanianie do działań, np. do inwestycji, często z użyciem wizerunku znanych osób. Narzędzia AI umożliwiają generowanie fałszywych informacji opatrzonych przekonującymi zdjęciami, realistycznym materiałem wideo lub „nagraniem” rzekomej kompromitującej rozmowy. Technologia deepfake pozwala na dosłowne „włożenie w usta” dowolnej osoby dowolnych słów, co można wykorzystać np. do wyłudzania pieniędzy przez telefon, podszywając się pod członka rodziny przy użyciu wygenerowanego głosu.

Deepfake’i stały się narzędziem propagandy i walki politycznej. Przykładem jest popularne w sieci zdjęcie, które rzekomo przedstawia kandydata na prezydenta USA, Donalda Trumpa, ratującego kotka przed utonięciem podczas powodzi (fot. 3).

Fot. 3. Źródło: https://www.chron.com/news/houston-texas/article/Fake-photo-Trump-saving-cats-during-Harvey-12203385.php

Media społecznościowe, z miliardami aktywnych użytkowników i użytkowniczek na całym świecie, błyskawicznie rozprzestrzeniają takie informacje. W rezultacie mogą one wpływać na nasze sympatie, antypatie i decyzje polityczne.

Innym problemem wynikającym z działania algorytmów AI są tzw. bańki informacyjne. Algorytmy decydują, jakie treści, w tym ogłoszenia o pracę, są nam wyświetlane, a jakie nie. Badania organizacji Global Witness pokazały, że ogłoszenia o pracy w recepcji są wyświetlane głównie kobietom, podczas gdy te z branży IT częściej trafiają do mężczyzn.

AI może również powodować tzw. dyskryminację algorytmiczną. Treści generowane przez AI potrafią utrwalać stereotypy płciowe, rasowe, a także uprzedzenia wobec osób starszych, niepełnosprawnych czy queerowych. Jak pokazały m.in. badania dr Anny Górskiej, sztuczna inteligencja na prompt „osoba naukowa”, „lekarz” wygeneruje w 90% obrazy mężczyzn a nie kobiet. Kwestie te świetnie tłumaczy książka Kathy O’Neill Broń Matematycznej Zagłady, która pokazuje, jak pozornie neutralna sztuczna inteligencja wzmacnia istniejące uprzedzenia.

W jakim kierunku, Pani zdaniem, będzie następował rozwój AI?

Obserwując rozwój technologii AI, dostrzegam przynajmniej trzy kluczowe kierunki. Pierwszy to tzw. wirtualni agenci – technologie, które nie tylko wyszukują informacje i wspierają proces myślowy, ale również realizują kompleksowe działania i komunikują się z ludźmi w naturalnym języku. Wyobraźmy sobie, że chcemy zorganizować szkolenie w firmie. Obecnie, za pomocą aplikacji AI, możemy przygotować agendę, znaleźć salę i firmę szkoleniową. Taki agent AI mógłby nawet zarezerwować salę, przygotować zaproszenia i rozesłać je do uczestniczek/ów.

Drugi kierunek to technika „łańcucha myśli” – jednoczesna praca chatbota na różnych promptach, które są zestawiane w celu wygenerowania najlepszych odpowiedzi. Technika ta wspiera rozwiązywanie bardziej złożonych zadań, które wymagają precyzyjnych analiz. Przykładem aplikacji zdolnych do tego jest OpenAI o1 czy wspomniany wcześniej Nemotron.

Trzeci obszar prac to tzw. „ucieleśnione AI”, czyli sztuczna inteligencja zintegrowana w konkretnych narzędziach, takich jak roboty, autonomiczne pojazdy czy okulary inteligentne. Niedawno dużą uwagę przyciągnęły roboty zademonstrowane przez firmę Google DeepMind, które potrafią wykonywać zadania wymagające precyzji ruchowej, takie jak wiązanie sznurowadeł.

Równocześnie widzę przeciwny trend – rosnące zainteresowanie wiedzą i danymi niezależnymi od AI. Strona internetowa mojej firmy, w tym strefa wiedzy, pozostaje obszarem wolnym od AI, przeznaczonym wyłącznie dla ludzi i idei wynikających z ludzkiej aktywności, bez udziału sztucznej inteligencji.

Czy wprowadzenie ustawodawstwa regulującego kwestie sztucznej inteligencji, takich jak AI Act może zahamować ten rozwój?

Wielu osób z branży AI jak i z polityki twierdzi, że regulacje hamują rozwój sztucznej inteligencji. Uważam jednak, że ten argument jest błędny. Po pierwsze, nie istnieje naukowo potwierdzona negatywna korelacja między surowymi regulacjami prawnymi a poziomem innowacyjności kraju. Innowacyjność zależy od wielu czynników, takich jak dostęp do finansowania, zasoby danych, kultura organizacyjna oraz kompetencje badaczy – a nie tylko od warunków prawnych. Kraje o wysokim poziomie innowacyjności, jak Niemcy, kraje skandynawskie czy Korea Południowa, wykazują także dużą rolę państwa jako regulatora. Ponadto, sektory o wysokich wymogach regulacyjnych, takie jak farmaceutyka, są innowacyjne pomimo konieczności spełniania rygorystycznych norm.

Rozwój AI powinien opierać się nie na interesach inwestorów i Big Tech-u z Doliny Krzemowej, ale na demokratycznej kontroli ze strony państwa i społeczeństwa. Wiedza i decyzje o AI nie mogą być zmonopolizowane przez wąską grupę jej twórców.

Co doradziłaby Pani tym, którzy chcą w sposób świadomy i efektywny korzystać z systemów generatywnej AI?

Systemy AI stanowią cenną pomoc w pracy biurowej, analityce, komunikacji z klientami oraz w tworzeniu polityk publicznych. Warto je testować i śledzić ich rozwój, bo stale pojawiają się nowe, interesujące możliwości. Stosując je, należy pamiętać o kilku zasadach.

Po pierwsze, dbajmy o ochronę danych osobowych i wrażliwych, zwłaszcza w wersjach bezpłatnych aplikacji, gdzie dane z promptów podlegają zarówno automatycznej, jak i ręcznej (ludzkiej) weryfikacji w celu ulepszania produktu. Zawsze powinniśmy ocenić, czy wpisywane przez nas informacje mogą być udostępniane osobom z zewnątrz. Nie wpisujmy w czaty AI informacji takich jak imiona, nazwiska, adresy, numery kont czy inne dane chronione prawem. Jeśli pracujemy na dokumentach zawierających takie dane, powinniśmy je najpierw zanonimizować – są do tego specjalne aplikacje.

Po drugie, należy pamiętać, że AI może generować błędne informacje, czyli „halucynować”. Dlatego zawsze warto weryfikować przytoczone przez AI źródła, cytaty i dane.

Po trzecie, przedsiębiorcy oraz pracownicy sektora publicznego powinni nie polegać jedynie na obietnicach i atrakcyjnych demonstracjach technologii AI. Warto pytać o konkretne przykłady udanych wdrożeń. Firmy często reklamują AI jako rozwiązanie wszystkich problemów, ale należy oczekiwać dowodów skuteczności w rzeczywistych sytuacjach. Jeśli osoba próbująca ci coś sprzedać – pomysł lub technologię – nie potrafi wyjaśnić, jak to działa, powinno to zapalać w twojej głowie czerwone światło.

Po czwarte – testuj, próbuj i podążaj za swoją ciekawością. Efektywność możemy budować właśnie w procesie uczenia się, eksperymentowania i dostosowywania narzędzia do naszych potrzeb i celów.

Dziękuję za rozmowę.